Décryptage rédigé par Gabriel Kasmi, chercheur postdoctoral à l’école des Mines de Paris

La transition énergétique repose en grande partie sur un déploiement massif des énergies renouvelables, et notamment de l’énergie solaire photovoltaïque (PV). Une part significative de cette croissance repose sur les installations en toiture, de petite taille, pour lesquelles les registres existants de raccordements - s’ils existent - sont souvent incomplets. Dans un contexte de forte croissance du PV sur toiture, une cartographie précise, complète et fiable des installations est nécessaire afin d’améliorer l’insertion de ces systèmes - dont le poids dans la production électrique globale est croissant - sur le réseau.

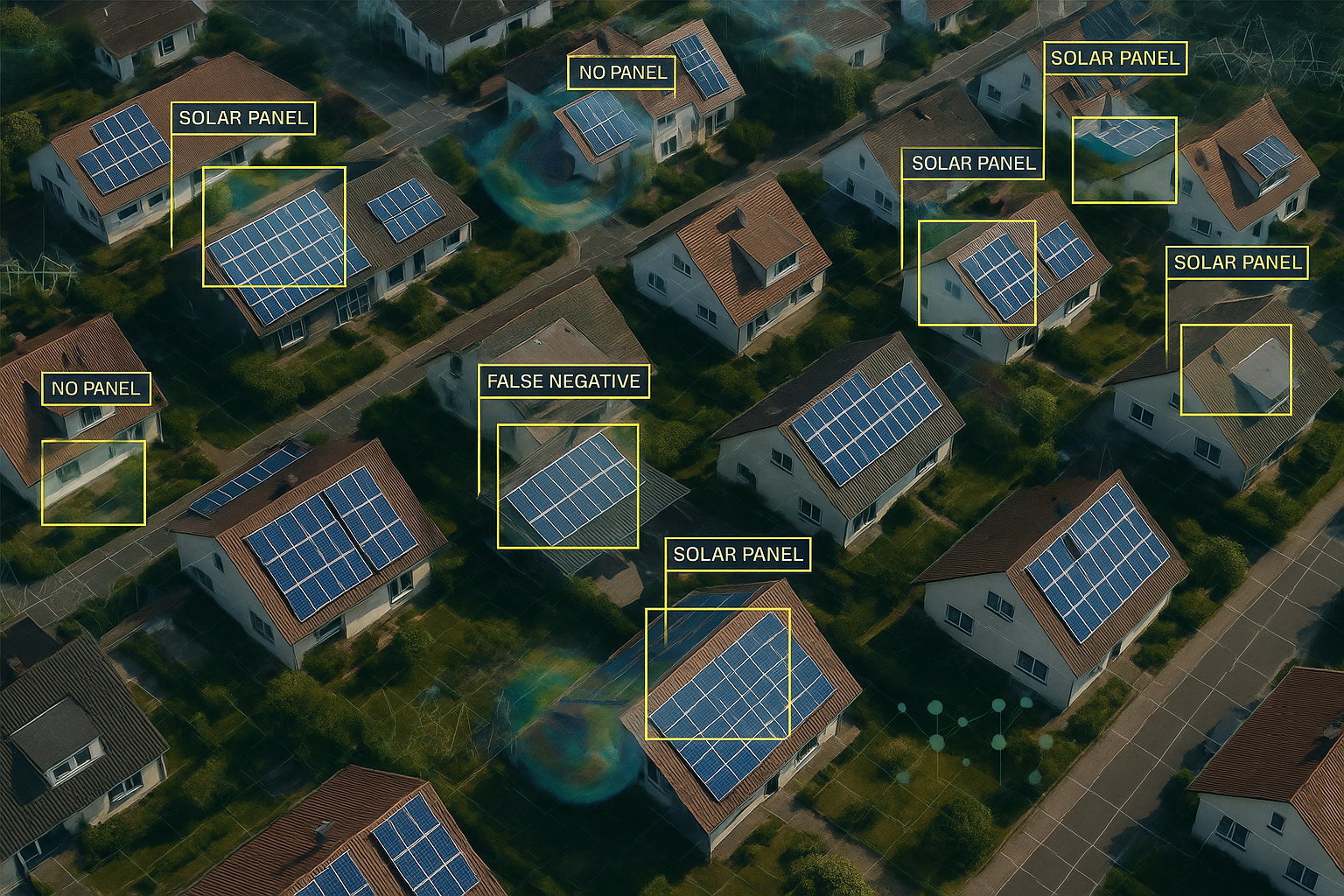

Face à ce défi, l’intelligence artificielle (IA), couplée à l’imagerie aérienne ou satellite, permet de cartographier à grande échelle des installations PV sur toiture. De telles données sont précieuses pour évaluer, compléter et corriger les données existantes. L’IA peut ainsi grandement faciliter l’estimation à l’échelle d’un pays les caractéristiques techniques individuelles des systèmes PV (surface, orientation, inclinaison et puissance installée) à partir d’images aériennes et de données géospatiales. Autrement dit, l’IA apparaît comme un levier essentiel pour améliorer l’observabilité du parc PV, pouvant ainsi contribuer à son insertion sur le réseau électrique dans un contexte de forte croissance.

Néanmoins, l’un des principaux freins à l’adoption des modèles d’IA par les acteurs de la filière PV réside dans leur manque de transparence. Il est souvent reproché aux réseaux de neurones, en dépit de leurs performances remarquables, d’être des “boîtes noires” ; en raison de la difficulté à interpréter leur processus de décision. En pratique, cette opacité pose une limite : ces modèles sont sensibles aux écarts (changement de lieu, type de prise de vue, etc) entre les données d'entraînement et les données réelles (distribution shifts), qui peuvent engendrer un effondrement soudain et imprévisible de leurs performances. Or, de telles variations sont fréquentes dans les cas d’usage réels, ce qui remet en question la robustesse et la fiabilité de ces outils dans un contexte opérationnel.

Pour répondre à cette limite, les approches d’explicabilité (XAI, eXplainable Artificial Intelligence) fournissent des outils permettant de comprendre le processus de décision de modèles “boîte noire”. Cette meilleure compréhension permet non seulement d’améliorer la transparence vis-à-vis de l’utilisateur final, mais peut également contribuer à l’amélioration de la fiabilité de ces algorithmes, favorisant ainsi leur applicabilité dans des cas d’applications tels que la télédétection de systèmes PV sur toiture.

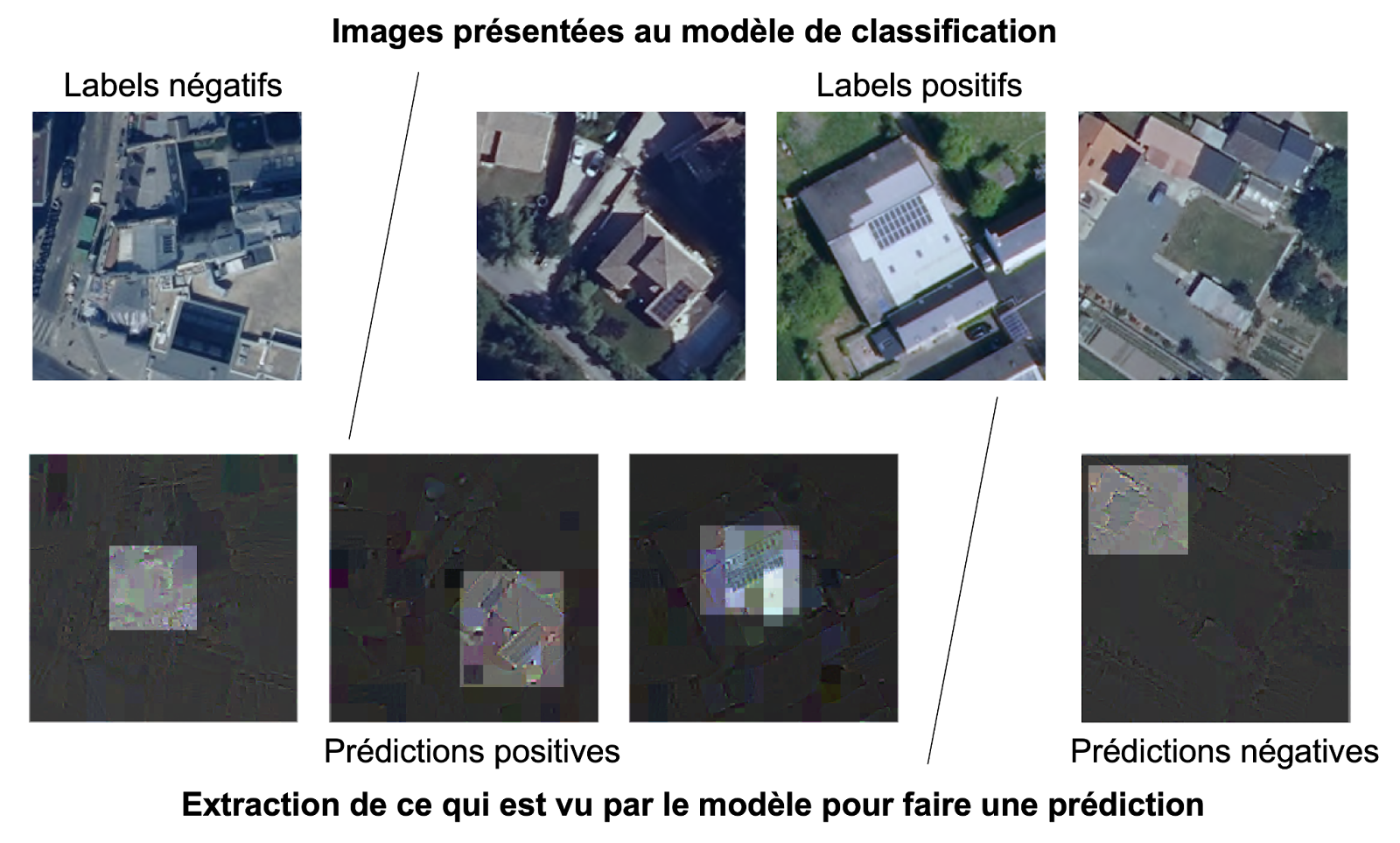

Dans une recherche récente, une méthode d’explicabilité novatrice, consistant à décomposer la prédiction du modèle dans l’espace des ondelettes, a été proposée. Les ondelettes sont un outil mathématique permettant de représenter une image à différents niveaux de détails, ce qui aide à mieux comprendre quelles informations le modèle utilise pour détecter un panneau PV. Comme illustré sur la figure, cette méthode d’explicabilité permet de mettre en avant le fait que les modèles existants de détection de panneaux PV associent de manière prépondérante des motifs assimilés à des grilles avec la présence d’un panneau sur l’image.

Ce constat a une triple implication. Tout d’abord, en explicitant ce que “voit” le modèle, il est possible d’expliquer son comportement, notamment les raisons d’occurrence des faux positifs et des faux négatifs et ainsi comprendre pourquoi les variations statistiques affectent le modèle: dans le cas de la détection de panneaux PV, il a été montré que les conditions d’acquisition de l’image aérienne, qui peuvent atténuer l’importance du motif grillé sur l’image, conduisait à une chute des performances à travers une hausse des faux négatifs. Ensuite, le processus de décision du modèle étant rendu plus transparent, l’utilisateur final est plus en mesure de se l’approprier et par conséquent d’anticiper son comportement et de comprendre ses limites. Enfin, il permet de questionner la qualité et la représentativité des données utilisées pour entraîner le modèle et identifier des biais potentiels dans ces données.

Grâce à l’explicabilité, les modèles d’IA gagnent en transparence et en fiabilité, facilitant leur adoption par les acteurs du photovoltaïque. En clarifiant leur fonctionnement, elle permet d’anticiper leur comportement, d’identifier d’éventuels biais et de mieux intégrer ces outils dans les processus métier.

Figure : Exemples d’images classifiées par un modèle de détection. Des exemples d’images présentées au modèle sont représentées sur la première ligne.

Les labels correspondent à la vraie classe des images. La seconde ligne représente l’information extraite à partir de cette image par le modèle, selon les détails décrits ici. La prédiction correspond au label prédit par le modèle, qui ne coïncide pas nécessairement avec la vraie classe. L’image minimale ainsi extraite montre que le motif en grille est prépondérant pour faire une classification. Si ce dernier est absent (à droite), alors l’image positive est classifiée comme négative (faux négatifs). Au contraire, si ce motif est perceptible sur l’image (à gauche), alors le modèle peut avoir tendance à classifier une image négative comme positive (faux positif).